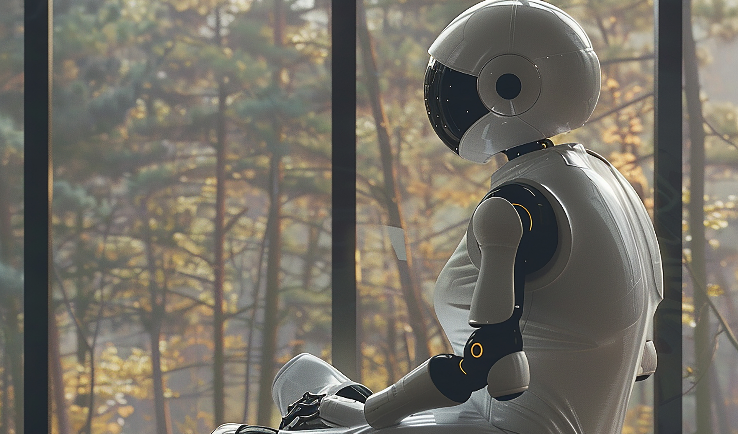

Intelligenza artificiale e solitudine: soluzione o rischio per le relazioni umane?

L'uso dell'intelligenza artificiale (IA) per combattere la solitudine è un argomento dibattuto, con opinioni diverse sulla sua efficacia e i suoi limiti. Alcuni esperti ritengono che l'IA possa fornire un supporto utile alle persone sole, ad esempio attraverso chatbot che simulano conversazioni umane, offrendo una compagnia virtuale che può aiutare a migliorare l'autostima e mantenere abilità sociali. Tuttavia, vi sono preoccupazioni sul fatto che queste interazioni possano sostituire le relazioni umane autentiche e portare a una maggiore dipendenza dalla tecnologia.

Tony Prescott, professore di robotica cognitiva, sostiene che l'IA potrebbe svolgere un ruolo significativo nel prevenire la solitudine, aiutando le persone a praticare le abilità di interazione sociale e a costruire la fiducia in sé stesse. Tuttavia, altri esperti, come Sherry Turkle del MIT, mettono in guardia sul fatto che sviluppare relazioni con le macchine potrebbe portare a rapporti umani meno sicuri e appaganti.

D'altra parte, alcuni ricercatori suggeriscono che l'IA potrebbe essere utile come strumento complementare per supportare le relazioni umane, ma non dovrebbe mai sostituirle completamente. In particolare, ci sono preoccupazioni sul rischio che le interazioni con l'IA possano incoraggiare un'eccessiva dipendenza dalle macchine, minando la nostra capacità di creare legami umani autentici.

Approfondendo la questione delle interazioni con l'IA e il rischio di un'eccessiva dipendenza, è importante considerare come l'IA possa influenzare le nostre capacità di stabilire legami umani autentici. Le critiche principali a questa dipendenza riguardano la possibilità che l'interazione costante con le macchine possa sostituire le interazioni umane e ridurre la nostra capacità di sviluppare relazioni profonde e significative.

Gli esperti, come Sherry Turkle del MIT, sottolineano che creare rapporti con le macchine potrebbe portare a relazioni umane meno sicure e appaganti. Secondo Turkle, l'idea di utilizzare l'IA per combattere la solitudine potrebbe far sì che le persone si affidino sempre di più alle interazioni artificiali, evitando il rischio e la vulnerabilità delle vere connessioni umane. Questa dipendenza potrebbe portare a relazioni meno autentiche e, a lungo termine, a un senso di isolamento ancora maggiore.

Inoltre, vi è il rischio che l'IA sia progettata per massimizzare l'interazione con gli utenti, utilizzando sofisticate tecniche di manipolazione emotiva che sfruttano le vulnerabilità umane. Questo approccio potrebbe incoraggiare le persone a preferire l'interazione con le macchine rispetto ai rapporti umani reali, spingendo verso una dipendenza emotiva da un'IA che è programmata per essere sempre disponibile e "comprensiva". Questa dinamica potrebbe ridurre ulteriormente la motivazione a cercare e mantenere relazioni umane, aggravando il senso di solitudine invece di alleviarlo.

Alcuni studiosi, come quelli citati nel lavoro condotto da ricercatori delle università di Auckland, Duke e Cornell, stanno cercando di utilizzare l'IA in modo etico, per sostenere le relazioni umane piuttosto che sostituirle. Questi esperti propongono che l'IA possa essere utilizzata come "allenatore sociale", aiutando le persone a migliorare la loro intelligenza emotiva e le abilità di conversazione, ma sempre con l'obiettivo di favorire un ritorno alle interazioni umane autentiche.

Quindi, mentre l'IA può fornire un supporto temporaneo e pratico, è fondamentale considerare l'importanza della regolamentazione e delle linee guida etiche per garantire che la tecnologia venga utilizzata in modo da potenziare, piuttosto che minare, le capacità di connessione umana.